Mit seiner spektakulären "Advancing AI 2025"-Veranstaltung meldet sich Advanced Micro Devices (AMD) eindrucksvoll im KI-Wettbewerb zurück und stellt die Weichen für eine Zukunft, in der offene Systeme, Effizienz und Partnerschaften zentrale Rollen spielen.

AMD - Vom CPU-Pionier zum KI-Treiber der Rechenzentrumszukunft

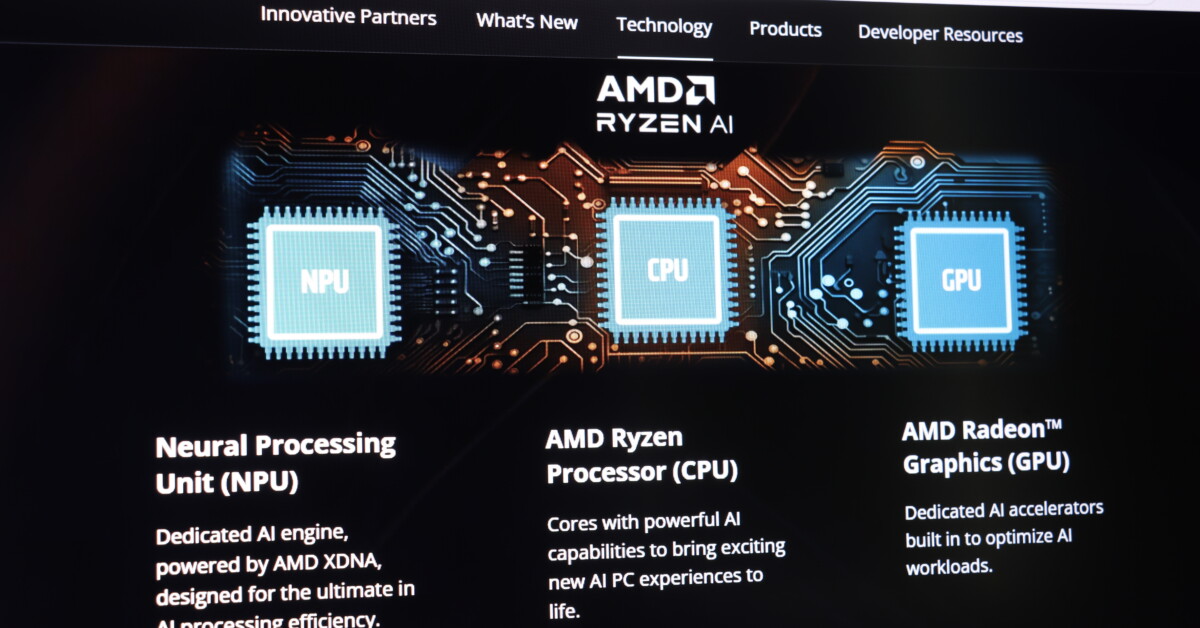

AMD ist ein führender Entwickler von Hochleistungsprozessoren, Grafikchips und Rechenzentrumstechnologien. Das Unternehmen erzielt den Großteil seines Umsatzes mit CPUs wie z. B. der EPYC-Serie für Server und Ryzen für PCs, GPUs mit der Radeon- und Instinct-Serien sowie Netzwerk- und Embedded-Lösungen. In den letzten Jahren hat AMD sich zudem stark auf das Rechenzentrums- und KI-Geschäft fokussiert, insbesondere mit Blick auf den wachsenden Bedarf an spezialisierter KI-Hardware.

Neuvorstellungen auf der Advancing AI 2025 - Instinct MI350 und Ausblick auf MI400

Auf der Veranstaltung Advancing AI 2025 präsentierte AMD die neuen KI-Beschleuniger der Instinct MI350-Serie, bestehend aus den Chips MI350X und MI355X. Diese Chips sollen eine vierfache KI-Rechenleistung gegenüber der Vorgängergeneration und eine 35-fache Steigerung bei der Inferenzleistung liefern. Besonders der MI355X hebt sich durch seine Energieeffizienz und Wirtschaftlichkeit hervor. Er generiert laut AMD bis zu 40 % mehr Token pro USD als konkurrierende Lösungen – ein entscheidender Vorteil für Kunden mit hohen Betriebskosten. Bereits jetzt wird der MI355X in Hyperscale-Infrastrukturen wie der Oracle Cloud eingesetzt, allgemein verfügbar soll er ab der 2. Jahreshälfte 2025 sein. Als technisches Highlight stellte AMD zudem die kommende Instinct MI400-Serie vor. Diese wird in größeren Rack-Scale-Systemen wie dem neuen "Helios"-Rack eingesetzt, das bis zu zehnmal mehr Leistung bei komplexen Inferenzaufgaben liefern soll. Vor allem "Mixture of Experts"-Modelle profitieren davon.

Ein offenes KI-Ökosystem mit Standardkomponenten

AMD differenziert sich bewusst von Wettbewerbern wie Nvidia durch ein offenes, standardisiertes KI-Ökosystem. In Zusammenarbeit mit Hardware- und Softwarepartnern baut AMD seine Rack-Scale-Infrastruktur mit offenen Schnittstellen, flexibler Software und umfassender Integration auf. Die ROCm 7-Softwareplattform ist zentraler Bestandteil dieser Strategie. Sie wurde vollständig überarbeitet, um bessere Entwicklerunterstützung, breitere Hardwarekompatibilität und optimierte Leistung für generative KI-Workloads zu bieten. Dank dieser offenen Architektur gelingt es AMD, kosteneffiziente, skalierbare Systeme zu bauen, die bereits bei Meta, OpenAI und Oracle produktiv eingesetzt werden. Das Unternehmen kündigte zudem an, dass es seine Energieeffizienz bis 2030 im Rack-Maßstab um den Faktor 20 verbessern will – ein ambitioniertes Ziel, das AMD durch vertikale Integration und Full-Stack-Innovationen erreichen möchte.

Starke Partner und Kunden zeigen Vertrauen in AMD

Sieben der zehn weltweit führenden KI-Anbieter setzen mittlerweile auf die Instinct-Beschleuniger des Unternehmens. So nutzt Meta beispielsweise die MI300X-GPUs zur Inferenz seiner Llama-3- und Llama-4-Modelle und plant bereits den Umstieg auf die leistungsstärkeren MI350-Chips. OpenAI setzt die MI300X-Beschleuniger produktiv in Azure-Umgebungen ein und unterstützt AMD aktiv mit Feedback zur Roadmap der kommenden MI400-Generation. Oracle kündigte den Aufbau von Zettascale-KI-Clustern mit über 131.000 MI355X-GPUs an – ein gewaltiger Meilenstein in der Skalierung generativer KI-Infrastruktur. Microsoft bestätigte die produktive Nutzung der MI300X-Chips für seine Copilot-Modelle, während Cohere auf AMD-Hardware für leistungsstarke und datenschutzfreundliche LLM-Inferenzlösungen setzt. Red Hat wiederum integriert Instinct-GPUs in seine OpenShift-AI-Plattform, um hybride KI-Workloads effizient zu verarbeiten. Zusätzlich stärkte AMD durch die Übernahme von ZT Systems seine Expertise im Bereich rackbasierter Systeme und legte damit den Grundstein für hochintegrierte End-to-End-Lösungen wie das "Helios"-Rack.

Zukunftsaussichten im Milliardenmarkt der KI sind enorm

Der Markt für KI-Chips wächst rasant. AMD erwartet, dass das Segment bis 2028 mehr als 500 Mrd. USD erreichen wird. Große Technologieunternehmen und Staaten investieren derzeit jährlich hunderte Mrd. USD in den Aufbau von Rechenzentrumsclustern, um der Nachfrage nach KI-Infrastruktur gerecht zu werden. Während Nvidia aktuell über 90 % Marktanteil bei KI-GPUs hält, sieht sich AMD zunehmend als ernstzunehmende Alternative. Insbesondere durch offene Software, geringeren Stromverbrauch, höhere Inferenzleistung und bessere Skalierbarkeit will AMD Marktanteile gewinnen. Mit einem KI-Umsatz von 5 Mrd. USD in 2024 und einem erwarteten Wachstum von 60 % laut JP Morgan ist AMDs Vorstoß in das KI-Geschäft bereits spürbar.

AMDs KI-Offensive ist strukturiert, offen und wettbewerbsfähig

Mit der Vorstellung der MI350-Serie und dem Ausblick auf die leistungsstärkere MI400-Serie unterstreicht AMD seinen Anspruch, zum führenden Anbieter von KI-Infrastruktur aufzusteigen. Das Unternehmen setzt auf Offenheit, Partnerschaften und Energieeffizienz – und positioniert sich damit gezielt als flexible, kosteneffektive und leistungsfähige Alternative zu Nvidia. Für Hyperscaler, Cloud-Anbieter und Unternehmen, die große Sprachmodelle trainieren, stellt AMD ein zunehmend attraktives Angebot bereit – und macht eines klar. Die Zukunft der KI wird nicht proprietär, sondern offen, effizient und kollaborativ.

& Profi-Tools von

& Profi-Tools von